2025 год стал переломным моментом для дипфейков. То, что ещё несколько лет назад казалось сырой демонстрацией возможностей ИИ, сегодня превратилось в технологию, способную убедительно копировать лица, голоса и даже манеру поведения реальных людей. Причём настолько хорошо, что подделки всё чаще вводят в заблуждение не только обычных пользователей, но и организации с профессиональными системами проверки. Возникает закономерный вопрос: если глазам и ушам больше нельзя верить, то на что вообще можно опереться?

Речь идёт не только о качестве, но и о масштабах. По оценке компании в сфере кибербезопасности DeepStrike, число дипфейков в интернете выросло с примерно 500 тысяч в 2023 году до около 8 миллионов в 2025-м. Это почти 900% роста в год. В условиях социальных сетей, коротких видео и видеозвонков низкого разрешения синтетические ролики стали практически неотличимы от настоящих — по крайней мере для неподготовленного зрителя.

Именно это сочетание — лавинообразный рост объёма и почти человеческая убедительность — делает дипфейки особенно опасными. Контент распространяется быстрее, чем его успевают проверить, а внимание аудитории давно фрагментировано.

Три технологических прорыва

Стабильное видео без «артефактов»

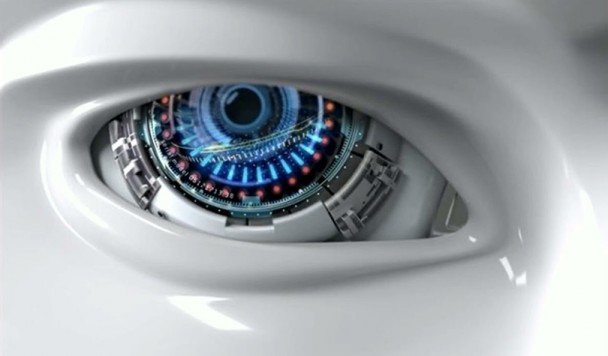

Первый ключевой сдвиг произошёл в генерации видео. Современные модели научились поддерживать так называемую временную согласованность: движения выглядят логично, личность человека остаётся постоянной от кадра к кадру, а происходящее не «рассыпается» визуально. Алгоритмы разделяют информацию об идентичности человека и о движении. В результате одну и ту же мимику или жесты можно «надеть» на разные лица, а одно лицо — заставить двигаться по-разному.

Самое важное — исчезли типичные визуальные «подсказки», по которым раньше легко вычисляли дипфейк: дрожание контуров лица, странные искажения вокруг глаз или челюсти, мерцание кожи.

Голос, который невозможно отличить

Вторая революция произошла в синтезе речи. Сегодня для создания убедительного клона голоса достаточно всего нескольких секунд аудиозаписи. ИИ воспроизводит интонации, ритм, паузы, эмоции и даже дыхание. Это уже не лабораторный эксперимент, а инструмент массового мошенничества. Крупные торговые сети сообщают о тысячах звонков в день, сгенерированных ИИ, — и привычные «звоночки», по которым раньше можно было распознать подделку, практически исчезли.

Демократизация: дипфейк за несколько минут

Третий фактор — доступность. Инструменты нового поколения, включая обновлённые модели вроде Sora 2 от OpenAI и Veo 3 от Google, а также десятки стартапов, снизили порог входа почти до нуля. Достаточно описать идею, поручить языковой модели написать сценарий — и через минуты получить готовое аудиовизуальное видео. Более того, ИИ-агенты способны автоматизировать весь процесс целиком. Масштабная генерация сюжетных дипфейков больше не требует команды специалистов.

Почему это серьезно

Когда почти неотличимые от реальности «персоны» начинают массово появляться в ленте новостей, последствия становятся ощутимыми. Дипфейки уже используются для распространения дезинформации, целенаправленных атак, травли и финансовых мошенничеств. Часто вред наносится ещё до того, как кто-то понимает, что имеет дело с подделкой.

Главный тренд 2026 года — переход к синтезу в реальном времени. Речь идёт не о заранее отрендеренных роликах, а о «живых» дипфейках, способных реагировать на собеседника прямо во время видеозвонка. Фокус смещается от статичного реализма к поведенческой согласованности: ИИ будет воспроизводить не просто внешний вид человека, а его манеру двигаться, говорить и взаимодействовать с окружающими в разных ситуациях.

Мы приближаемся к эпохе, когда можно будет создать полностью синтетического участника видеоконференции или интерактивного «актёра», чьё лицо, голос и жесты мгновенно подстраиваются под запрос. Для мошенников это означает переход от записанных роликов к адаптивным аватарам, которые отвечают на вопросы и подстраиваются под реакцию жертвы.

По мере того как разрыв между реальным и синтетическим контентом сокращается, человеческая интуиция перестаёт быть надёжной линией обороны. Простое «внимательное рассматривание пикселей» больше не работает. Акцент смещается на инфраструктурные решения: криптографическую подпись медиафайлов, системы подтверждения происхождения контента и стандарты вроде Coalition for Content Provenance and Authenticity. Дополнять их будут многофакторные криминалистические инструменты, анализирующие сразу изображение, звук и поведение.

Иначе говоря, доверие в цифровом мире придётся выстраивать не на уровне ощущений, а на уровне технологий.