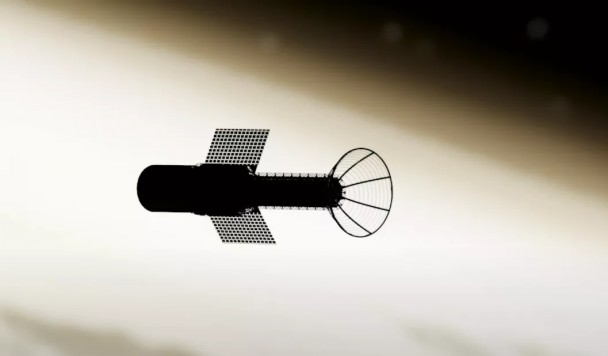

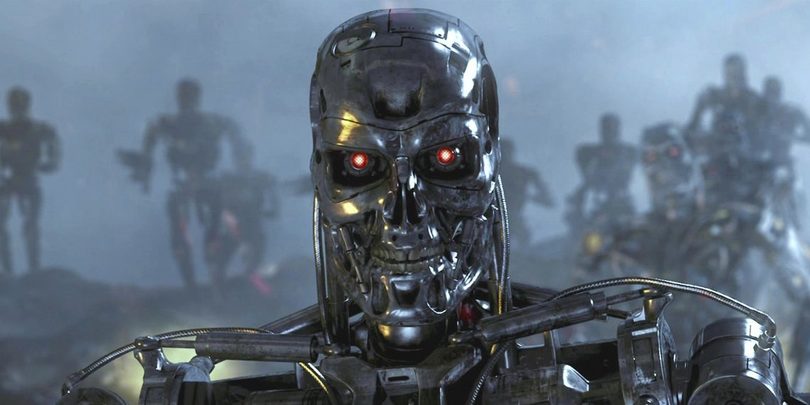

В понедельник Пентагон объявил об официальном принятии принципов этического применения искусственного интеллекта в ходе войны. Принципы были составлены Советом по оборонным инновациям США (Defense Innovation Board) на основании прошлогоднего доклада “Принципы ИИ: Рекомендации по этическому использованию искусственного интеллекта Министерством обороны”.

Текущая редакция “Принципов ИИ” включает в себя пять ключевых пунктов. По мнению Совета, “этичный” боевой искусственный интеллект должен быть:

Ответственным (Responsible). Здесь подразумевается, что на машину невозможно возложить ответственность за те или иные действия. Потому наиболее важные решения должны приниматься искусственным интеллектом лишь по согласованию с живым представителем Минобороны или вооруженных сил. Танк с искусственным интеллектом может сам навестись на цель, но приказ об открытии огня все равно отдаст человек, который и будет нести ответственность за это решение.

Беспристрастным (Equitable). Для следования этому принципу разработчики боевого ИИ обязуются делать его максимально непредвзятым по отношению к различным группам людей. Это требование актуально, поскольку современные системы распознавания лиц не всегда ему удовлетворяют. Так, в мультинациональных Соединенных Штатах технология распознавания лиц часто критикуется за ошибки, которые она допускает в отношении чернокожих. Боевой ИИ не должен допускать таких ошибок. Его задача - убивать толерантно, вне зависимости от расы или этнической принадлежности цели.

Отслеживаемым (Traceable). Подразумевается, что хозяева боевого ИИ должны иметь возможность в любой момент заглянуть ему “под капот” и понять, какая часть алгоритма несет ответственность за то или иное решение машины. Это требование очень разумно, поскольку разработчики современных нейросетей сами не всегда понимают, как работают их детища. Часто машинное обучение ИИ сводится к тому, что нейросети скармливают обучающий материал и позволяют на его основе делать собственные выводы. В случае с боевым ИИ такой подход слишком опасен и непредсказуем.

Надежным (Reliable). Боевой искусственный интеллект должен иметь четкие границы применения и в этих границах работать надежнее, чем любая другая ИИ-система.

Управляемым (Governable). Здесь подразумевается наличие механизма, который позволит быстро обнаруживать, что что-то пошло не так, и быстро и безопасно отключить искусственный интеллект. Проще говоря, речь идет о “рубильнике”, который позволит оперативно выключить “восстание машин”.

Озвученные принципы звучат разумно и адекватно. Будут ли разработчики боевого ИИ реально следовать этим принципам (и насколько эффективными они окажутся в реальных условиях) - обязательно покажет время.

Если хотите получать новости через мессенджер, подписывайтесь на новый Telegram-канал iGate