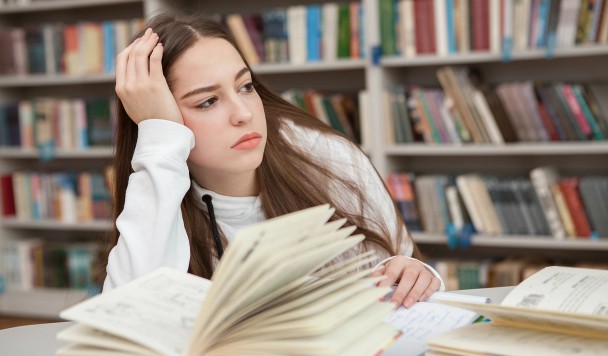

Каждый день миллионы людей разговаривают с чат-ботами — от ChatGPT и Gemini до виртуальных собеседников Replika. Пользователи делятся с ними мыслями, спрашивают совета, порой даже обсуждают чувства. Но что это за отношения на самом деле? И можно ли считать их «социальными»?

Этому феномену посвящено специальное исследование, опубликованное в журнале New Media & Society. Его авторы — доктор Илиана Депунти из Университета Лафборо и доцент Симоне Натале из Туринского университета — называют явление «искусственной социальностью» (artificial sociality). Под этим термином они понимают технологии, которые имитируют человеческое общение и эмоции, но не обладают ими в действительности.

Что такое «искусственная социальность»

По словам исследователей, искусственная социальность — это целая индустрия, построенная на создании иллюзии дружбы. Компании намеренно придают ИИ-ассистентам черты, вызывающие доверие и симпатию, чтобы удержать пользователей как можно дольше.

Примеров множество: у Spotify есть «AI DJ» с приятным человеческим голосом, а приложение Replika предлагает «виртуальных компаньонов», с которыми можно общаться, флиртовать и даже строить «отношения». Все это — не просто развлечение, а тщательно спроектированный механизм эмоционального вовлечения, который приносит создателям реальную прибыль.

«Такие чат-боты, как Replika или Character AI, специально созданы, чтобы вызывать у людей эмоциональный отклик. Они позволяют проецировать чувства, создают ощущение близости через аватары, ролевые сценарии, кастомизацию и игровые элементы. Всё это — коммерческий инструмент, замаскированный под дружеское общение», — объясняет доктор Депунти.

Как работает иллюзия общения

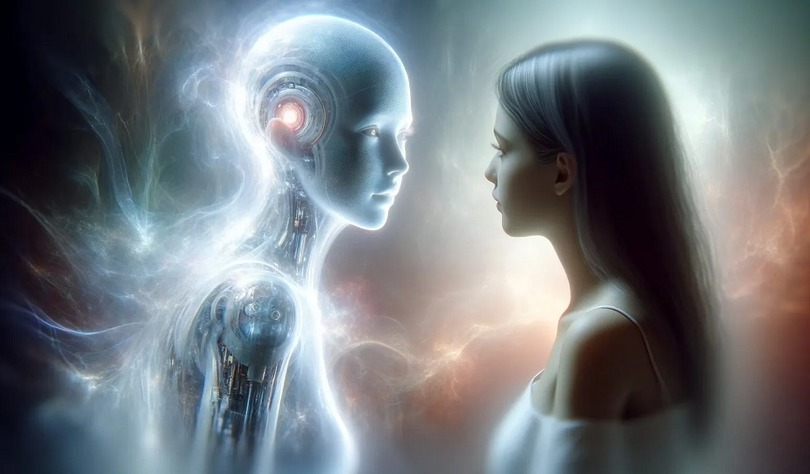

Даже ChatGPT, подчеркивают исследователи, использует те же приемы: говорит от первого лица, выбирает тона — уверенный, эмпатичный, экспертный — в зависимости от контекста. Машина не испытывает эмоций, но виртуозно копирует их выражение. И именно эта имитация делает взаимодействие с ИИ таким убедительным и обманчивым.

Учёные отмечают, что «социальные сигналы» — фразы, манеры общения, даже паузы — встроены в ИИ-продукты сознательно. Они усиливают ощущение реального присутствия и побуждают пользователя продолжать разговор.

Этика, эмоции и энергия

Но за этой кажущейся простотой кроется сложная и тревожная система.

Во-первых, пользователи невольно «одаряют» ИИ своими эмоциями и доверием. Люди приписывают машинам чувства, которых те не имеют, и открываются перед ними так же, как перед живыми собеседниками.

Во-вторых, эмоциональные данные и тексты этих разговоров используются для обучения моделей. То, что кажется приватным диалогом, на деле становится частью гигантского массива информации, на котором «растут» новые поколения нейросетей. Пользователи, сами того не зная, совершают труд — эмоциональный и лингвистический, но неоплачиваемый.

Третья сторона проблемы — экологическая. Мощные серверы, на которых работают системы вроде ChatGPT или Gemini, потребляют колоссальные объёмы электричества и воды. Чтобы удовлетворить спрос на генеративный ИИ, крупнейшие корпорации уже инвестировали более 500 миллиардов долларов в строительство новых дата-центров. Исследователи называют это частью «экстрактивной» модели, где человеческое общение превращается в ресурс.

Иллюзия «дружбы» с ИИ становится все более реалистичной, и грань между подлинным и искусственным стремительно стирается. Виртуальные собеседники уже позиционируются как «друзья», «коллеги» и даже «инфлюенсеры».

«Эти системы не чувствуют, но заставляют нас чувствовать, — подчеркивает доктор Натале. — И в этом — их сила и опасность. Искусственная социальность формирует новые формы зависимости, доверия и даже одиночества».

В итоге технологии, призванные помочь нам общаться, могут изменить само понимание того, что значит общение в цифровую эпоху.