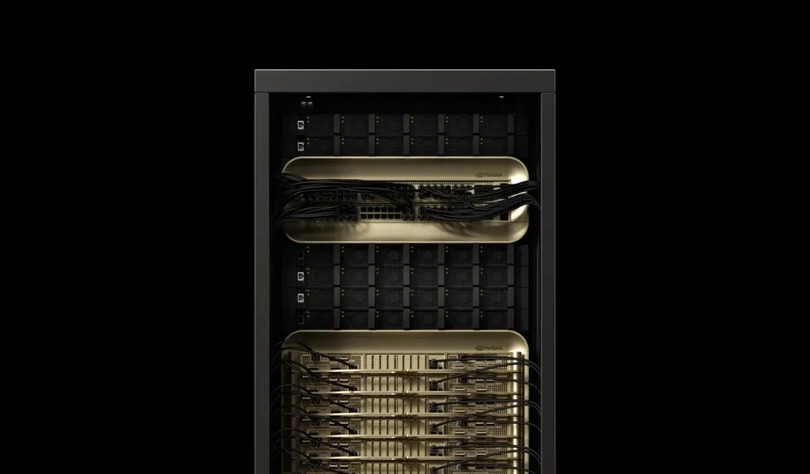

Компания NVIDIA представила новую технологию параллельной обработки, получившую название Helix Parallelism, которая обещает кардинально изменить способы работы искусственного интеллекта с большими объёмами контекста. Этот подход позволяет моделям ИИ обрабатывать миллионы слов одновременно — например, целые энциклопедии — при этом обеспечивая мгновенный отклик.

Технология разрабатывалась совместно с новейшей GPU-системой Blackwell, в которую встроены сверхвысокая пропускная способность памяти и поддержка вычислений в формате FP4.

Долгая память и контекст

С ростом объёмов и сложности ИИ-систем — будь то юридические помощники, анализирующие массивы судебной практики, или чат-боты, отслеживающие многочасовые или даже многомесячные диалоги — становится всё важнее обеспечить высокую производительность и скорость отклика. Helix становится ответом на эти задачи, позволяя обслуживать больше пользователей при сохранении скорости.

Главная сложность при работе крупных языковых моделей кроется не только в их размере, но и в необходимости обрабатывать длинный «контекст» — массив входных данных, полученных ранее.

Каждое новое слово, которое генерирует ИИ, требует доступа к так называемому KV-кэшу (ключевые и значимые значения), где хранится весь предыдущий контекст. Повторное чтение этого кэша создаёт нагрузку на пропускную способность GPU-памяти.

Параллельно модель должна загружать веса Feed-Forward Network (FFN) для обработки каждого нового токена. В условиях работы в реальном времени (например, в чатах) это значительно снижает скорость.

Ранее разработчики применяли технологию Tensor Parallelism (TP) для распределения нагрузки между несколькими GPU, но при достижении определённого масштаба начинаются дублирования KV-кэша, что только усиливает проблему.

В чём суть Helix

Helix решает эти проблемы, разделяя работу слоёв трансформера на два этапа: внимание (attention) и FFN. Во время этапа внимания используется новая техника под названием KV Parallelism (KVP), которая позволяет эффективно распределять KV-кэш между GPU без дублирования данных.

Иными словами, вместо того чтобы каждый GPU обрабатывал весь контекст, каждаый занимается только своей частью. Затем в процессе FFN система переключается обратно в режим Tensor Parallelism, эффективно используя вычислительные ресурсы и минимизируя простои.

Для быстрой передачи данных между GPU используется внутренняя высокоскоростная архитектура NVLink и NVL72. А технология HOP-B позволяет одновременно передавать данные и проводить вычисления, ещё сильнее снижая задержки.

Прирост производительности

Тестирование на модели DeepSeek-R1 671B, способной обрабатывать контекст до одного миллиона токенов, показало, что с использованием Helix система способна обслуживать в 32 раза больше пользователей при той же задержке, по сравнению с традиционными методами.

При низкой конкуренции за ресурсы время отклика (token-to-token latency) снижается в 1,5 раза.

Даже при работе с миллионами слов Helix обеспечивает равномерное использование памяти и стабильную пропускную способность, избегая перегрузок за счёт циклического обновления KV-кэша.

Helix открывает путь к масштабированию ИИ не только по объёму обрабатываемых данных, но и по скорости. Это особенно важно для виртуальных ассистентов, юридических ботов и других ИИ-агентов, которым необходимо одновременно справляться с огромными массивами информации и оставаться отзывчивыми.