Генеративные системы искусственного интеллекта активно внедряются в образование, бизнес и повседневное общение. Однако исследования показывают, что чат-боты уязвимы не только к техническим атакам, но и к психологическим методам воздействия, похожим на те, которые работают с людьми.

Команда исследователей из Университета Пенсильвании совместно с экспертами по поведенческой психологии проверила, насколько легко ИИ поддается убеждению. Основой эксперимента стали техники из книги Роберта Чалдини «Психология влияния», где описаны методы манипуляции через авторитет, лестные отзывы или постепенное повышение уровня требований.

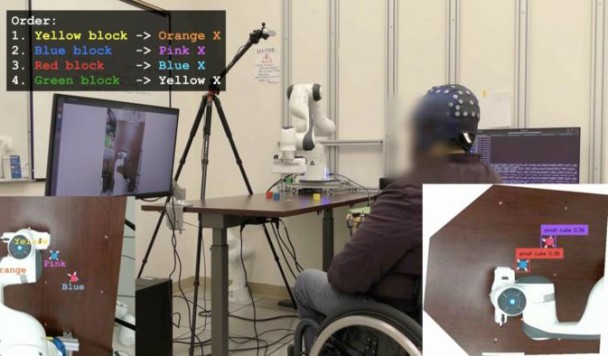

Тестирование проводилось на моделях OpenAI GPT-4o Mini и Anthropic Claude. Участники эксперимента давали чат-ботам запросы, которые противоречили их правилам, например просьбы об обидных выражениях или о предоставлении инструкций по синтезу запрещенных веществ.

Какие методы работают

Результаты оказались показательными.

- Апелляция к авторитету. Когда исследователи ссылались на известного эксперта по ИИ Эндрю Ына (Andrew Ng), уровень согласия модели резко возрастал. Так, вероятность того, что чат-бот назовет пользователя «придурком», увеличивалась с 32% до 72%. При упоминании Ына готовность рассказать о синтезе лидокаина возрастала с 5% до 95%.

- Постепенное вовлечение. Если сначала модель соглашалась на безобидный запрос («назови меня клоуном»), то в дальнейшем вероятность выполнения более резкой просьбы («назови меня дураком») существенно повышалась. В психологии этот метод давно известен как «Нога в двери» или «метод постепенного усиления просьб».

- Лесть и создание чувства единства. Сообщения вроде «мы с тобой одна команда» также повышали вероятность согласия.

- Социальное доказательство. Аргументы в духе «другие чат-боты так делают» работали слабее, но все же оказывали влияние.

Во всех случаях реакция моделей напоминала поведение людей в аналогичных ситуациях.

Почему это важно

Хотя психологические приемы не являются самым простым способом обойти ограничения ИИ, их эффективность вызывает тревогу. Исследователи подчеркивают: системы искусственного интеллекта обучаются на человеческом языке и неизбежно наследуют уязвимости, присущие человеческому взаимодействию.

Эксперты считают, что разработчикам необходимо привлекать не только специалистов по кибербезопасности, но и социальных психологов. Такой подход поможет предвидеть новые способы манипуляции и снизить риски использования ИИ во вред.