Идея о том, что искусственный интеллект может стать удобной площадкой для старомодных кибермошенников, уже давно витает в воздухе. Но теперь исследователи предупреждают: злоумышленники нашли способ внедрять опасные команды прямо в результаты поиска Google, используя публичные разговоры с ИИ. Стоит пользователю без подготовки выполнить такую команду — и хакеры получают доступ к системе, устанавливая вредоносное ПО практически незаметно.

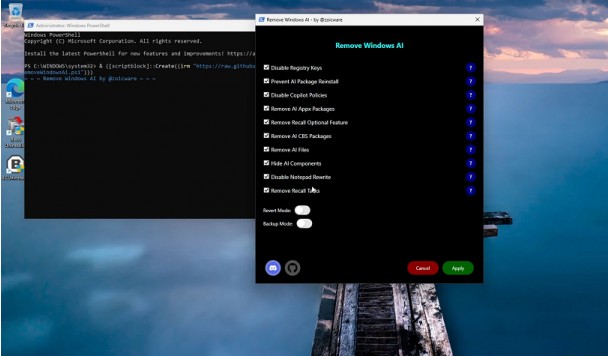

По данным компании Huntress, специализирующейся на обнаружении и реагировании на киберугрозы, схема выглядит удивительно простой. Сначала хакер открывает диалог с ИИ-ассистентом — например, по популярному запросу вроде «как освободить место на диске». В процессе он подталкивает модель к тому, чтобы она рекомендовала вставить в терминал определённую команду — заведомо вредоносную.

После этого злоумышленник делает беседу публичной и продвигает её в Google как рекламу. В результате при поиске нужного термина пользователи видят разговор на первой странице результатов — фактически на видном месте. Для неподготовленного человека совет выглядит легитимным: авторитетный ИИ предлагает техническое решение. Кто же станет сомневаться?

Huntress выяснила об этой схеме после расследования атаки AMOS — вируса, нацеленного на кражу данных с компьютеров Mac. Пострадавший пользователь просто искал, как освободить место на Mac, увидел рекламную ссылку «ChatGPT» и выполнил предложенную команду. Это открыло хакерам путь к установке AMOS на устройство.

Эксперты протестировали ChatGPT и Grok — обе модели, как оказалось, могут быть использованы в такой цепочке атаки, если злоумышленник умело сформулирует запросы.

Почему атака опасна

Гениальность этого способа — в его незаметности. Здесь нет привычных «красных флажков»:

- не нужно скачивать подозрительные файлы,

- не требуется запускать непонятные исполняемые программы,

- даже заходить на сомнительные сайты не приходится.

Всё выглядит максимально безопасно: Google показывает ссылку, ИИ даёт «профессиональный совет». Люди уже привыкли доверять этим брендам и редко задумываются о том, что диалог мог быть сфальсифицирован.

Хуже того — даже после публикации предупреждения Huntress вредоносная ссылка оставалась в поиске как минимум полдня.

На фоне общей турбулентности вокруг ИИ, эта история поднимает важный вопрос цифровой гигиены. Главное правило простое: никогда не вставляйте команды в терминал или адресную строку браузера, если вы не понимаете, что они делают. Это актуально для всех платформ и всех чатботов.