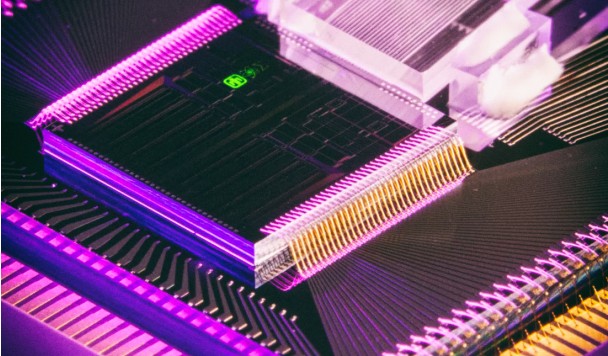

Китайские исследователи объявили о прорыве, который может изменить курс развития искусственного интеллекта (ИИ) благодаря модели, копирующей поведение нейронов в человеческом мозге.

Новая модель ИИ, созданная командой, может достигать вычислительных мощностей без чрезмерно высокого потребления энергии кремниевыми процессорами.

Чтобы создать модель, ученые попытались преодолеть разрыв между большими и сложными работами моделей ИИ и сложными внутренними процессами человеческого мозга.

Революция, к которой могут привести результаты этой работы, заключается в возможности разработки ИИ, который вообще не полагается на кремниевые процессоры или чипы.

Энергоэффективный ИИ

Несмотря на множество применений, рост ИИ также привел к увеличению спроса на энергию. Модели ИИ являются крупными потребителями энергии. А с постоянно расширяющейся ролью ИИ во всех областях кризис будет только увеличиваться.

С другой стороны, мы имеем человеческий мозг. Он более сложный, чем любая созданная на данный момент модель ИИ, но ему требуется относительно немного энергии для выполнения всех своих обязанностей.

Ученые из Института автоматизации Китайской академии наук и Пекинского университета объединились с целью разработать модель ИИ, которая сможет выполнять сложные задачи при меньшем потреблении энергии.

“Мозгоподобный” искусственный интеллект

Ученые, связанные с проектом, называют новую модель «моделью внутренней сложности». Она названа так, поскольку при решении задач пытается воспроизводить внутренние процессы человеческого мозга.

Тесты, проведенные исследовательской группой, уже подтвердили эффективность данной модели в выполнении многочисленных задач. Также эксперименты также показали, что она может обеспечить новые методы и теоретическую поддержку для интеграции динамических характеристик нейробиологии в ИИ, а также предложить осуществимые решения для оптимизации и повышения практической эффективности моделей ИИ.

Исследование опубликовано в журнале Nature Computational Science.