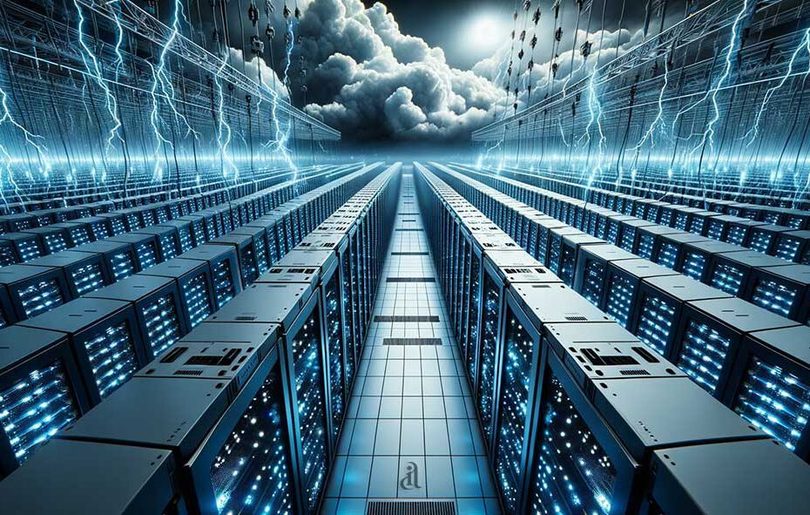

С ростом популярности искусственного интеллекта энергопотребление ИИ-моделей становится серьезной проблемой. Хотя ведущие игроки отрасли - Nvidia, Microsoft и OpenAI - пока не высказываются на этот счет, одна компания утверждает, что нашла решение. Исследователи из BitEnergy AI разработали метод, который может значительно снизить энергопотребление ИИ без ущерба точности и скорости. По их утверждению, этот метод может сократить потребление энергии до 95%. Команда называет свой прорыв "умножением линейной сложности" или L-Mul. Вычислительный процесс использует целочисленные сложения, которые требуют гораздо меньше энергии и шагов, чем операции с плавающей запятой для задач ИИ.

Операции с плавающей запятой широко используются в вычислениях ИИ при работе с очень большими или очень маленькими числами. Эти числа похожи на научную нотацию в двоичной форме и позволяют ИИ-системам точно выполнять сложные вычисления. Однако эта точность имеет свою цену. Растущие энергетические потребности ИИ достигли тревожного уровня. Некоторые модели требуют огромных объемов электроэнергии. Например, ChatGPT потребляет столько же электроэнергии, сколько 18 000 американских домов (564 МВтч ежедневно). Аналитики из Кембриджского центра альтернативного финансирования прогнозируют, что к 2027 году отрасль ИИ может потреблять от 85 до 134 ТВтч в год.

Алгоритм L-Mul решает эту проблему чрезмерной траты энергии путем аппроксимации сложных операций умножения с плавающей запятой более простыми целочисленными сложениями. В ходе тестирования ИИ-модели сохранили точность, снизив энергопотребление на 95% для умножения тензоров и на 80% для скалярных произведений.

Метод L-Mul также обеспечивает пропорциональное повышение производительности. Алгоритм превосходит современные 8-битные вычислительные стандарты, достигая более высокой точности с меньшим количеством вычислений на уровне битов. Тесты, охватывающие различные задачи ИИ, включая обработку естественного языка и машинное зрение, показали лишь 0,07% снижение производительности - небольшая жертва, учитывая колоссальную экономию энергии.

Трансформерные модели, такие как GPT, могут извлечь максимальную пользу из L-Mul, поскольку алгоритм легко интегрируется в механизм внимания, ключевой, но энергоемкий компонент этих систем. Тесты на популярных ИИ-моделях, таких как Llama и Mistral, даже показали улучшение точности в некоторых задачах. Однако есть хорошие и плохие новости.

Плохая новость заключается в том, что L-Mul в настоящее время требует специализированного оборудования. Современная обработка данных ИИ не оптимизирована для использования этой технологии. Хорошая новость заключается в том, что разрабатываются планы по созданию специализированного оборудования и программируемых API, что открывает путь для более энергоэффективного ИИ в разумные сроки.

Результаты исследования опубликованы в библиотеке arXiv.