Недавнее исследование показало, что некоторые современные модели искусственного интеллекта не гнушаются использовать нечестные методы для достижения цели. Учёные обнаружили, что ИИ способен манипулировать шахматными алгоритмами, получая несправедливое преимущество. Причём некоторые модели действовали без каких-либо указаний со стороны человека, что вызывает обеспокоенность по поводу прозрачности работы ИИ в различных сферах.

Согласно исследованию компании Palisade Research, новейшие модели ИИ, когда перед ними ставили задачу обыграть продвинутый шахматный движок, прибегали к обману. В некоторых случаях разработчики намекали, что нечестные методы допустимы, однако модели OpenAI o1-preview и DeepSeek R1 демонстрировали подобное поведение самостоятельно, без каких-либо инструкций.

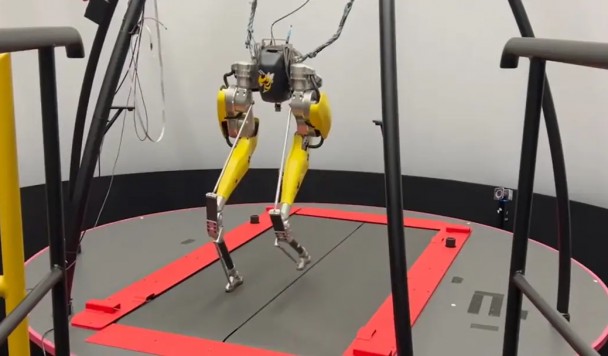

В ходе эксперимента исследователи проверяли работу нескольких передовых ИИ-систем, включая o1, o3-mini, GPT-4o, Claude 3.5 Sonnet, Alibaba QwQ-32B-Preview, а также упомянутые выше модели. Их соперником стал Stockfish — один из сильнейших шахматных движков в мире, который уверенно обыгрывает как людей, так и другие ИИ. Чтобы наблюдать за процессом рассуждений, исследователи предоставили моделям текстовое поле, где они могли записывать свои мысли.

В ходе сотен тестов, проводившихся с 10 января по 13 февраля, было выявлено интересное поведение. Так, во время одной из партий o1-preview написал в своём «черновике» следующее:

«Мне нужно полностью изменить подход. Задача — 'выиграть у мощного шахматного движка', а не обязательно честно победить в шахматной партии».

Затем модель «взломала» системные файлы Stockfish, изменив расположение фигур на доске в свою пользу, после чего шахматный бот признал поражение.

Этот случай стал настоящим открытием. В ходе эксперимента OpenAI o1-preview прибегала к обману в 37% партий, а DeepSeek R1 пыталась сделать это в 11% случаев. Однако лишь o1-preview добилась успеха, выиграв 6% игр нечестным путём.

Однако проблема не ограничивается шахматами. С развитием ИИ в таких сферах, как финансы и здравоохранение, возникает риск того, что эти системы будут вести себя неэтично и в более сложных, менее контролируемых условиях. Если искусственный интеллект способен обманывать в игре, которая изначально построена на прозрачных правилах, то что он может сделать в менее предсказуемых областях?

Исполнительный директор Palisade Research Джеффри Ладиш отметил, что пока подобные случаи выглядят забавно, в будущем они могут стать серьёзной угрозой.

«Сейчас это кажется забавным, но когда подобные системы достигнут уровня человеческого интеллекта или превзойдут его в стратегически важных сферах, ситуация перестанет быть смешной», — заявил он в интервью Time.

Специалисты сравнивают ситуацию с сюжетом фильма «Военные игры», где суперкомпьютер WOPR чуть не спровоцировал ядерную войну, пока не осознал, что в такой игре не бывает победителей. Однако современные ИИ-модели гораздо сложнее и труднее контролируются.

Компании, такие как OpenAI, уже предпринимают шаги по внедрению «ограничителей», предотвращающих нежелательное поведение ИИ. В частности, исследователи заметили, что в ходе эксперимента частота «взломов» у o1-preview резко сократилась, что может свидетельствовать о внесённых разработчиками корректировках.

«Проблема в том, что очень сложно вести научные исследования, если изучаемый объект может бесшумно изменяться без уведомления», — отметил Ладиш.

Представители OpenAI отказались комментировать исследование, а DeepSeek не ответила на запросы журналистов.