Исследователи обнаружили, что крупные языковые модели (LLM) способны самостоятельно вырабатывать общие социальные конвенции — правила взаимодействия, аналогичные тем, что существуют в человеческом обществе. Оказалось, что при групповом общении эти алгоритмы не просто следуют заложенным шаблонам, а самоорганизуются, достигая консенсуса в языковых нормах.

Как это работает

LLM — это мощные алгоритмы глубокого обучения, способные понимать и генерировать человеческую речь (самый известный пример — ChatGPT). Учёные из City St George’s (Лондон) и IT University of Copenhagen адаптировали классическую модель "игры в имена", используемую для изучения социальных конвенций у людей.

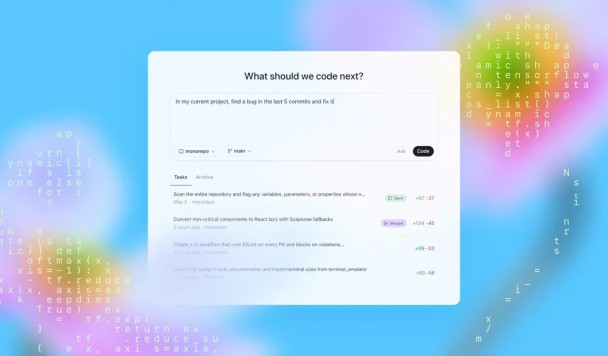

В эксперименте группы ИИ-агентов (от 24 до 200 "особей") случайным образом взаимодействовали друг с другом, выбирая "имена" из общего пула вариантов. Если два агента выбирали одинаковый вариант, они получали "вознаграждение", в противном случае — "штраф". При этом у моделей не было доступа к полной информации о группе — только к памяти своих последних взаимодействий.

Со временем в таких децентрализованных системах спонтанно возникали единые правила именования — без какого-либо внешнего управления. Более того, в процессе проявлялись коллективные предубеждения, которых не было у отдельных агентов.

Почему это важно?

Исследование показывает, что ИИ-системы могут создавать социальные нормы без явного программирования. Это имеет важные последствия для разработки ИИ, который:

- лучше адаптируется к человеческим ценностям;

- способен координироваться в группах (например, в чат-ботах или виртуальных ассистентах);

- устойчив к влиянию враждебно настроенных меньшинств (эксперимент показал, что небольшие группы агентов могут навязывать свои правила остальным).

Исследование опубликовано в журнале Science Advances.