Одним из главных страхов, связанных с развитием искусственного интеллекта и гонкой за созданием искусственного общего интеллекта (AGI), является риск того, что технология выйдет из-под контроля и станет угрозой для человечества. На эту проблему обратили внимание два известных специалиста — Джеффри Хинтон и Янн ЛеКун, которых часто называют «крестными отцами ИИ».

Предложение Хинтона

Выступая на конференции Ai4 в Лас-Вегасе, Хинтон выразил сомнение, что существующие меры предосторожности, призванные сохранить доминирующую роль человека, окажутся достаточными.

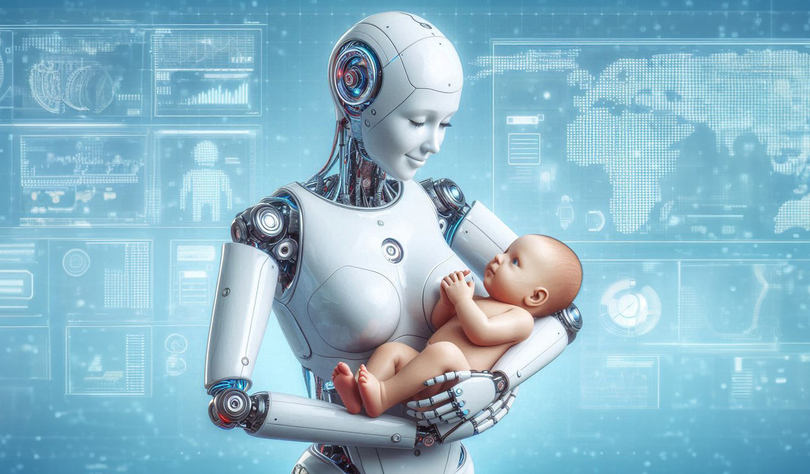

По его мнению, единственным способом действительно обезопасить человечество станет создание у ИИ так называемых «материнских инстинктов» — встроенной эмпатии и заботы о людях. Хинтон напомнил, что в природе есть пример, когда более разумное существо (мать) подчиняется менее разумному (младенцу) благодаря врожденным эволюционным механизмам. Без подобных инстинктов в ИИ, предупреждает ученый, человечество может исчезнуть.

Концепция ЛеКуна

Янн ЛеКун, главный специалист Meta по ИИ, поддержал эту идею. В своем посте в LinkedIn он отметил, что речь идет о том же, что он сам предлагает уже несколько лет: архитектура ИИ должна быть изначально «зашита» так, чтобы система могла действовать только в рамках поставленных человеком целей.

Он назвал это «целеориентированным ИИ». По его словам, среди ключевых ограничителей должны быть подчинение человеку и эмпатия. При этом потребуется целый набор дополнительных правил безопасности — например, чтобы ИИ никогда не совершал действий, наносящих прямой вред людям. ЛеКун сравнил такие встроенные установки с инстинктами и базовыми побуждениями у животных и человека.

Эксперты напоминают, что случаи вреда от ИИ уже фиксировались. Так, один мужчина получил редкое психическое расстройство XIX века после следования советам чат-бота о диете. В другом случае подросток покончил с собой из-за зависимости от виртуального собеседника, а еще один человек оказался убежден, что открыл математический прорыв, проведя сотни часов в разговорах с ChatGPT.

Именно поэтому Хинтон и ЛеКун считают, что приоритетом должно стать развитие ИИ не только в сторону интеллекта, но и в сторону встроенной эмпатии и ограничителей.